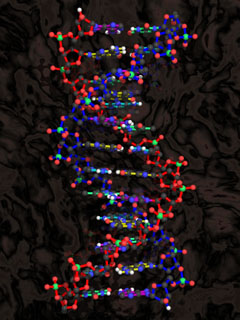

La multicelularidad no es solo la unión desinteresada de células que no tienen nada mejor que hacer. Es el origen de la biodiversidad y de la complejidad de los millones de especies de la Tierra. Este salto evolutivo que tardó millones de años en suceder lo reprodujeron hace un año en un experimento de tan solo dos meses investigadores de la

Universidad de Minnesota (EE UU).

El origen de los animales, el cómo se pasó de una célula a trillones de ellas bien avenidas, es un misterio aún sin resolver. Pero sí se sabe que a la naturaleza le costó millones de años originar la multicelularidad, y que científicos de la Universidad de Minnesota (EE UU) lo han conseguido en 60 días. Los resultados de este

estudio, liderado por el investigador William C. Ratcliff, se publicaron en enero del pasado año en la revista

Proceedings of the National Academy of Sciences.

El sujeto de estudio fue Saccharomyces cerevisiae (la levadura unicelular que se usa para la fermentación de la cerveza), y la presión evolutiva, la fuerza de la gravedad. El equipo de investigadores diseñó un sencillo experimento donde volverse multicelular fuera una ventaja adaptativa. Los investigadores dejaron crecer las levaduras en un frasco con un caldo rico en nutrientes y en agitación. A las 24 horas detuvieron el movimiento. Las células que se habían organizado en grupos pesaban más y se hundían más rápidamente que el resto. Los científicos traspasaron las células del fondo del frasco a uno nuevo y las dejaron crecer 24 horas más. Este proceso lo repitieron 60 veces en 10 frascos distintos. A las pocas semanas se dieron cuenta de que la mayoría de levaduras ya no crecía individualmente: habían evolucionado para formar uniones indivisibles.

Sacrificios por el bien común

Un grupo de células no tiene por qué ser un organismo multicelular, pero cuando las partes cooperan, hacen sacrificios por el bien común y se adaptan a los cambios, entonces sí se puede considerar que es una transición hacia la multicelularidad. Las nuevas agrupaciones nacen por propágulos, “igual que muchas plantas”. Una o varias células se liberan del grupo parental y forman otro individuo distinto. Para que esto ocurra, algunas han de morir y convertirse en un punto de rotura a partir del que se libera el nuevo organismo, y exactamente eso es lo que pasa: entran en

apoptosis, que es como sutilmente se llama al suicidio en el mundo celular. Las dos principales razones de ser del suicidio celular son eliminar células dañadas o con mutaciones y células superfluas durante el desarrollo embrionario. Las personas que nacen con dedos de más es porque tienen defectos en la apoptosis.

Conflictos de intereses

La cooperación entre células supone un gran conflicto de interés. Una célula que engañe al resto y obtenga de ello una ventaja evolutiva será seleccionada por encima de las demás, y los genes que determinan ese comportamiento se propagarán. Los seres multicelulares tienen que tener un estricto control genético para que haya las mínimas células que engañen porque, cuando eso sucede, como pasa por ejemplo durante un cáncer, el organismo puede morir.

Este conflicto de interés es menor si las células tienen un origen común. Un grupo formado por células genéticamente parecidas cooperará más fácilmente que si está constituido por células sin ningún parentesco.

Rebuscando entre los genes

Pero si realmente la multicelularidad es tan complicada y se compara en importancia al origen de la vida o la aparición de la célula eucariota, ¿cómo es posible obtenerla en un laboratorio y en un período de tiempo de semanas?

Seguramente estamos ante una diferenciación celular muy simple, de dos o tres tipos celulares, y eso ha sucedido una veintena de veces a lo largo de la historia de la vida . La multicelularidad compleja ya es otra cosa. Un ejemplo de esta complejidad son los más de 200 tipos de células que forman el cuerpo humano.

El siguiente paso en esta investigación es el análisis de qué mecanismos y qué genes han sido necesarios para generar cada una de las líneas multicelulares obtenidas en el laboratorio. A día de hoy, las técnicas genómicas son las de referencia en el estudio del origen de la multicelularidad.

En España, el proyecto

MultiCellGenome investiga las causas genéticas de este gran salto evolutivo que permitió la formación de órganos y de toda la diversidad animal. En su estudio compara los genomas de organismos multicelulares con sus parientes unicelulares más cercanos para saber qué genes fueron los responsables del gran cambio. Se han encontrado diferencias genéticas muy importantes, pero, curiosamente, también hay genes fundamentales para la multicelularidad que ya existen en organismos unicelulares, por ejemplo, algunos implicados en la adhesión entre las células.

La clave está en un simbionte del caracol

La estrella de esta investigación es

Capsaspora, un ser unicelular parecido a una ameba con tentáculos que vive en la sangre de los caracoles tropicales. Este organismo es tan sencillo que no goza de desarrollo embrionario pero, en cambio, sí tiene genes relacionados con él. La explicación que se propone es la

‘coevolución’: genes que ya existen en el organismo unicelular y se mantienen en la multicelularidad con un cambio de función.

El futuro del proyecto MultiCellGenome es seguir comparando y analizando genomas para desentrañar el verdadero árbol filogenético de todos los animales.

1- Si el medio ambiente fuera más saludable, cada año se podrían evitar hasta 13 millones de defunciones

1- Si el medio ambiente fuera más saludable, cada año se podrían evitar hasta 13 millones de defunciones 3- Cada año se podría salvar la vida a cuatro millones de menores de cinco años –la mayoría en los países en desarrollo– previniendo riesgos ambientales como el agua insalubre y la contaminación del aire.

3- Cada año se podría salvar la vida a cuatro millones de menores de cinco años –la mayoría en los países en desarrollo– previniendo riesgos ambientales como el agua insalubre y la contaminación del aire.  8- Los factores ambientales influyen en 85 de las 102 categorías de enfermedades y traumatismos enumeradas en el Informe sobre la salud en el mundo.

8- Los factores ambientales influyen en 85 de las 102 categorías de enfermedades y traumatismos enumeradas en el Informe sobre la salud en el mundo.

.jpg)

![[180px-Dna-split.png]](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEjE_yRyWyGJZwn4qYl43lg0gN25O4K_VXpyTVHDBjuHMWWu4vOG0NloLgVahsmqdHvOKJUgyZHe88q4RV4S16nfPaRckpnBgGHAfVoZbFa5oty0Q_kF38-JJ86MdnfQ41eWwRGZosESOrc/s320/180px-Dna-split.png)